정보 이론?

정보를 수치화하고 메세지를 효율적으로 압축하기 위한 방법으로 연구되었다.

동전의 앞면과 뒷면은 몇 비트로 표현할 수 있을까? > 0, 1 >> 1bit

맑음, 흐림, 비, 눈 => 몇 비트로 표현할 수 있을까? > 00, 01, 10, 11 >> 2bit

빈번하게 발생하는 상태에는 적은 bit로 표현하고 희소하게 발생하는 상태에는 높은 bit를 준다.

불확실성이 높다? VS 불확실성이 낮다

맑음, 흐림, 비, 눈 모두 0.25의 확률일 때 / 맑음 0.95, 흐림 0.04, 비 0.008, 눈 0.002

자기 정보(self-information)

분포 P의 확률로 일어나는 어떠한 사건 x에 대한 정보량 I(x)= -logP(x)

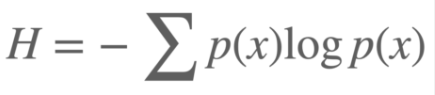

Entropy

불확실한 정도

평균적으로 몇 개의 질문을 해야 정보를 확인할 수 있는지.

Cross Entropy

확률 분포 P와 확률 분포 Q의 다름의 정도를 측정

크로스 엔트로피(Cross entropy)는 정보 이론에서 사용되는 개념 중 하나로, 두 확률 분포 간의 차이를 계산하는 방법 중 하나이다. 보통 예측 모델을 평가할 때, 모델이 예측한 확률 분포와 실제 분포 사이의 차이를 계산하여 모델의 정확도를 측정한다. 이 때 사용되는 함수 중 하나가 크로스 엔트로피 함수이다.

이 함수는 모델이 예측한 분포가 실제 분포와 같을 때 최소값을 가지며, 모델의 예측이 틀릴수록 값이 커진다.

다음과 같은 수식으로 표현한다.

H(p, q) = -Σ p(x) * log q(x)

여기서 p는 실제 분포, q는 모델이 예측한 분포를 나타낸다. 두 분포가 같을 때 크로스 엔트로피는 최소값 0을 가지며, 두 분포가 다를 때 값은 양수이다. 따라서 모델의 성능이 좋을수록 크로스 엔트로피 값은 작아지게 된다.

'AI' 카테고리의 다른 글

| 나이(Age)의 데이터 형태는 범주형인가, 수치형인가? (0) | 2023.05.20 |

|---|---|

| 로지스틱 회귀(Logistic Regression) (0) | 2023.04.25 |

| 베르누이 분포(Bernoulli distribution) (0) | 2023.04.24 |

| 베이즈 이론(Bayes' Theorem) (0) | 2023.04.24 |

| 확률과 확률 분포 (0) | 2023.04.24 |