728x90

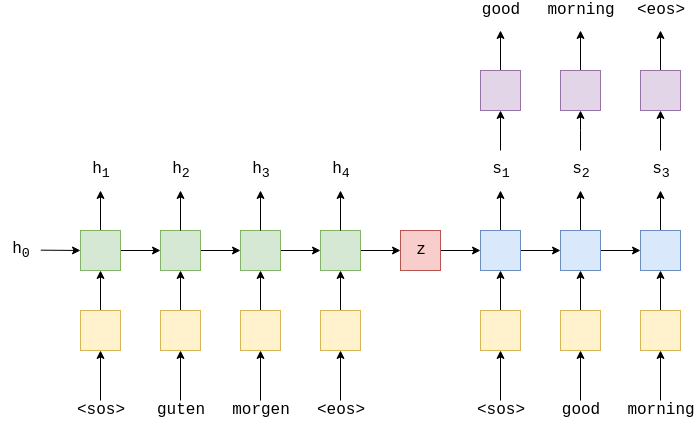

LSTM과 GRU가 RNN을 개선하는데 큰 역할을 했지만, Seq2Seq(Sequnce-to-Sequence) 모델은 RNN 기반의 아키텍처를 확장하여 더 복잡하고 다양한 시퀀스 학습 작업을 다룰 수 있다.

RNN을 개선한 LSTM과 GRU는 고정된 크기의 시퀀스를 처리하는 데 제한이 있다. 그러나 Seq2Seq 모델은 입력 및 출력 시퀀스의 길이가 가변적인 경우에 대해서도 처리할 수 있다. 이는 기계 번역과 같은 작업에서 매우 중요하다.

2014년 Seq2Seq 모델의 등장으로 인해 자연어 처리 및 기계 학습 분야에 큰 발전을 가져왔다. 이 모델은 텍스트 처리, 음성 처리, 이미지 처리 등 다양한 분야에서 활용되며 딥러닝 기반의 자연어 이해 및 생성 작업에 많이 사용된다.

728x90

'자연어 처리(NLP) 공부' 카테고리의 다른 글

| 자연어 처리 Task 모델 평가지표(Precision, Recall, F-measure...) (3) | 2023.12.07 |

|---|---|

| 언어 모델(Language Model) 공부 (2) | 2023.09.02 |

| Cell state and 4 Gates of LSTM (0) | 2023.09.02 |

| RNN의 한계점과 해결 방안 - LSTM, GRU (0) | 2023.09.02 |

| Sequence to Sequence(Seq2Seq)의 학습과 추론 과정의 차이 (0) | 2023.08.30 |