728x90

- Precision and Recall(정밀도와 재현율)

- Precision(정밀도) = 맞은 단어의 수 / 예측한 문장의 길이

모델이 True로 분류한 것이 True인 확률 - Recall(재현율) = 맞은 단어의 수 / 정답 문장의 길이

실제 True 중 예측한 True의 비율. 거짓 양성이 증가하면 정밀도는 감소한다.

≫ 의료 분야와 같이 생명과 직결되는 상황에서는 높은 recall이 중요할 수 있으며, 스팸 필터와 같이 거짓 양성을 최소화해야 하는 상황에서는 높은 precision이 중요할 수 있다.

- Precision(정밀도) = 맞은 단어의 수 / 예측한 문장의 길이

- F-measure = (precision x recall) / {1/2(precision + recall)}

precision과 recall의 조화평균 - BLEU score

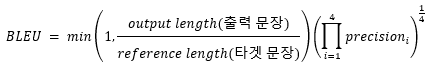

*BLEU(Bilingual Evaluation Understudy)

기계 번역 모델의 성능을 측정하는 데 사용되는 지표로 모델이 생성한 텍스트와 기준 텍스트 간의 n-gram 일치를 평가한다.

BLEU score는 recall이 아닌 precision 기반으로 한다. 그 이유는 번역 task에서 정답문장의 몇 단어가 빠져 재현율이 낮아져도 문장의 의미가 유사할 수 있지만, 문장에 없는 단어가 오역되어 정밀도가 떨어지면 영향이 클 가능성이 있기 때문이다.

- ROUGE score

텍스트 요약 및 번역 평가를 위한 지표. 주로 텍스트 생성 작업에서 사용되며, 생성된 텍스트와 기준 텍스트 간의 일치 정도를 측정한다.- ROUGE-N(N-gram overlap): N-gram 개수 기준

- ROUGE-L(Longest Common Subsequence): N-gram과 달리 순서나 위치 관계 고려

- ROUGE-W(Weighted overlap): Skip-gram 활용

ROUGE score는 0~1 사이의 값을 가지며, 1에 가까울수록 생성된 텍스트가 기준 텍스트와 일치하는 정도가 높다.

728x90

'자연어 처리(NLP) 공부' 카테고리의 다른 글

| 언어 모델(Language Model) 공부 (2) | 2023.09.02 |

|---|---|

| Seq2Seq의 등장 이유? (0) | 2023.09.02 |

| Cell state and 4 Gates of LSTM (0) | 2023.09.02 |

| RNN의 한계점과 해결 방안 - LSTM, GRU (0) | 2023.09.02 |

| Sequence to Sequence(Seq2Seq)의 학습과 추론 과정의 차이 (0) | 2023.08.30 |